🕵️♂️ Meta y otros te habrían espiado: descubre cómo proteger tu empresa y tu privacidad

La Inteligencia Artificial (IA) ha experimentado un rápido crecimiento que ha generado una enorme preocupación sobre su regulación y seguridad. La moratoria propuesta por expertos en IA, incluido el dueño de Tesla y Twitter, Elon Musk, sugiere limitar temporalmente el desarrollo de nuevas tecnologías de Inteligencia Artificial. Sin embargo, poner restricciones a la investigación y el desarrollo en este campo es como «poner puertas al campo». Determinar qué aspectos específicos de la IA se limitarían, qué empresas se verían afectadas y en qué países se aplicaría la moratoria son cuestiones que podrían complicar su implementación.

¿Por qué asusta tanto un futuro en el que la Inteligencia Artificial tenga poderes desbocados? Vamos a tratar de poner esta compleja materia en contexto en un campo que avanza día a día a un ritmo vertiginoso.

1.- Menos privacidad: La IA puede afectar a nuestra privacidad futura mediante el desarrollo de tecnologías de reconocimiento facial en espacios públicos. Aunque estas tecnologías pueden ayudar a identificar a delincuentes y mejorar la seguridad, también pueden invadir o anular la privacidad de las personas al recopilar y almacenar datos sobre sus movimientos y actividades sin su consentimiento. Además, el uso indebido de estos datos por parte de gobiernos o empresas podría concluir en la vigilancia masiva de los ciudadanos y en una violación de derechos fundamentales. Una auténtica distopía orwelliana.

2.- Discriminación por sesgo: Imaginemos que la contratación de personal se implemente en base a algoritmos. Si un algoritmo se entrena con datos históricos que reflejan sesgos raciales o de género, podría perpetuar estos sesgos al recomendar candidatos para los puestos de trabajo. Por ejemplo, si el algoritmo aprende que los empleados hombres han tenido un mejor desempeño en ciertos roles, podría favorecer a candidatos masculinos en el futuro, discriminando a las mujeres que solicitan el mismo puesto.

3.- Un mayor riesgo para la seguridad: Un ejemplo relacionado con la seguridad es el uso de la IA en ciberataques. Los hackers pueden utilizar algoritmos de IA para generar ataques de phishing más sofisticados, diseñando correos electrónicos y sitios web fraudulentos que engañan a las personas para que revelen sus datos personales y contraseñas. Además, la IA también podría utilizarse para identificar y explotar vulnerabilidades en sistemas de seguridad y redes, lo que podría poner en riesgo la información confidencial y la infraestructura crítica.

4.- Desplazamiento laboral: La IA ya está haciendo posible la automatización de empleos en la industria manufacturera. La implementación de robots y sistemas de IA capaces de realizar tareas repetitivas y rutinarias con mayor precisión y velocidad que los humanos ha llevado a la pérdida de empleos para los trabajadores en fábricas. Eso es ya ocurre en el presente. Aunque como sostengo en el libro “¿Qué robot se ha llevado mi queso?” la historia ha demostrado siempre que la tecnología no elimina puestos de trabajo pues, aunque algunas profesiones se vuelven obsoletas, aparecen otras nuevas.

Pero a medida que la IA continúa avanzando, es probable que también afecte a otros sectores, como el transporte, la atención al cliente y la medicina, lo que podría aumentar el desempleo y la desigualdad económica.

5.- Responsabilidad y transparencia en la toma de decisiones: ¿Y si los algoritmos son los que toman decisiones médicas? Si un sistema de IA recomienda un tratamiento inadecuado para un paciente, podría ser difícil determinar quién es responsable último del error: ¿el médico que siguió la recomendación del algoritmo? ¿los desarrolladores del sistema de IA? ¿los proveedores de datos utilizados para entrenar el algoritmo? Además, la falta de transparencia en el funcionamiento de los algoritmos de IA puede dificultar la comprensión y la explicación de por qué se tomaron ciertas decisiones, lo que podría socavar la confianza en la tecnología y la rendición de cuentas.

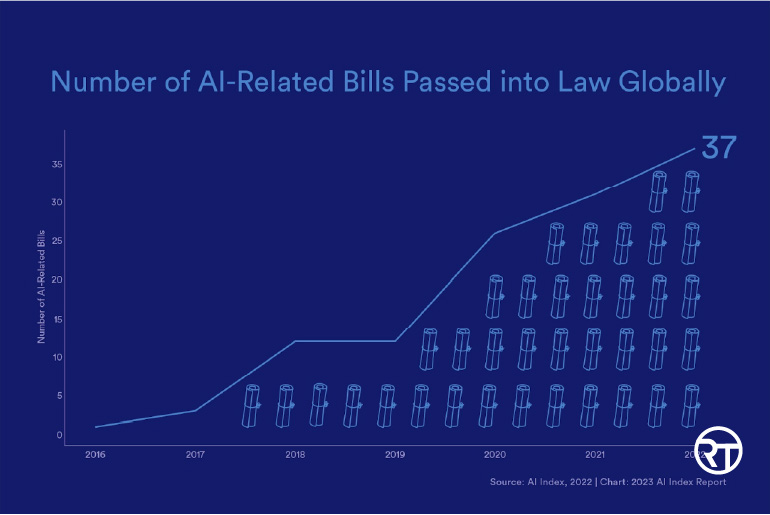

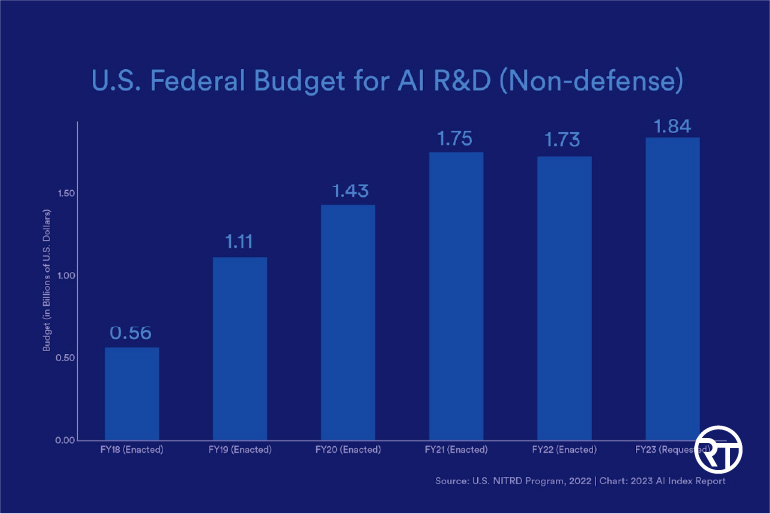

Imagina un viaje alrededor del mundo explorando cómo diferentes países están regulando la inteligencia artificial (IA). ¡Suena emocionante, ¿no?! Empezamos en Europa, donde el AI Act está en proceso y se espera que en 2025 exista un sistema regulatorio en todo el Espacio Económico Europeo (y quizás Suiza).

EE. UU. se centra en estándares voluntarios y ciberseguridad, China busca liderar y regular la IA mediante experimentación y regulación en áreas sensibles, Japón confía en la colaboración para desarrollar la «sociedad 5.0», Canadá lidera en regulación del sector público y evalúa normas para el sector privado. México, Australia, Singapur e India observan las iniciativas globales y adaptan sus normas actuales. La regulación de la IA varía desde estándares voluntarios hasta ambiciosos planes de liderazgo.

En el mundo de la regulación de la inteligencia artificial (IA), hay dos partidos en juego, ¡y la tensión es alta!

La UE busca normas aplicables a todos en su territorio, mientras que EE. UU. y China evitan regulaciones detalladas, esperando que sus estándares voluntarios se conviertan en referencia.

El tiempo juega en contra de Europa, con EE. UU. publicando estándares pronto y la UE tardando al menos dos años en tener legislación aplicable, lo que podría dejar sus normas obsoletas al entrar en vigor.

Desde una perspectiva pro consumidor y mercado, creo que grandes regulaciones pueden no ser la mejor solución para abordar las preocupaciones que surgen con la inteligencia artificial. En lugar de imponer prohibiciones y restricciones estrictas, se deberían considerar otras alternativas. Me atrevo a sugerir algunas…

Fomentar la autorregulación e incentivar a las empresas y organizaciones a desarrollar y adoptar sus propias pautas éticas y de responsabilidad en la investigación y el uso de IA. Establecer estándares y prácticas voluntarias para la industria de la IA. Promover la transparencia y la colaboración para compartir información sobre los avances y enfoques en IA. Esto permitiría a los interesados aprender unos de otros y desarrollar soluciones conjuntas a los problemas que enfrenta el campo. Y, por último, invertir en educación y concienciación. Asegurar que la sociedad en general esté informada sobre los desafíos y oportunidades que presenta la IA, lo que permitiría un debate más informado y equilibrado sobre cómo abordar las preocupaciones relacionadas con la tecnología.

Algunas pinceladas: